【初開催】OpenAI社の開発者向けカンファレンス

「ChatGPT」を世に解き放ったOpenAI社のイベント「OpenAI DevDay」が、2023年11月6日(日本時間だと11月7日)にアメリカ西海岸のサンフランシスコで開催されました。

今までの生活や働き方を日々大きく変え続けているOpenAI社ですが、今回初めて「Dev Day」ということで、Developers(開発者)向けのイベントを開催。人工知能の「開発」に関することに触れている人たちにとっては、この日を待ち侘びている人がとても多かった印象で、わたしの周りのAIに詳しそうな方々は、開催後も内容が凄すぎたために熱量が簡単には冷めそうにありません。

そんな2023年後半で一番ホットなAIイベントの一つである「OpenAI DevDay 2023」に関して、自分のAI学習も兼ねて内容全てを10項目に動画と記事でまとめてみました。

OpenAI DevDay 公式ページ : https://devday.openai.com

Udemyという動画プラットフォームにて、ChatGPT API の機能「Function Calling」を使ったLINE公式アカウントを作成する講座も出しています。今回の発表の目玉「GPT-4 Turbo」についても講座内で取り上げています。開発を全くしたことがない非エンジニアでも、プログラミングの基礎から丁寧に2時間半かけて解説していますので、併せて是非ご受講ください。

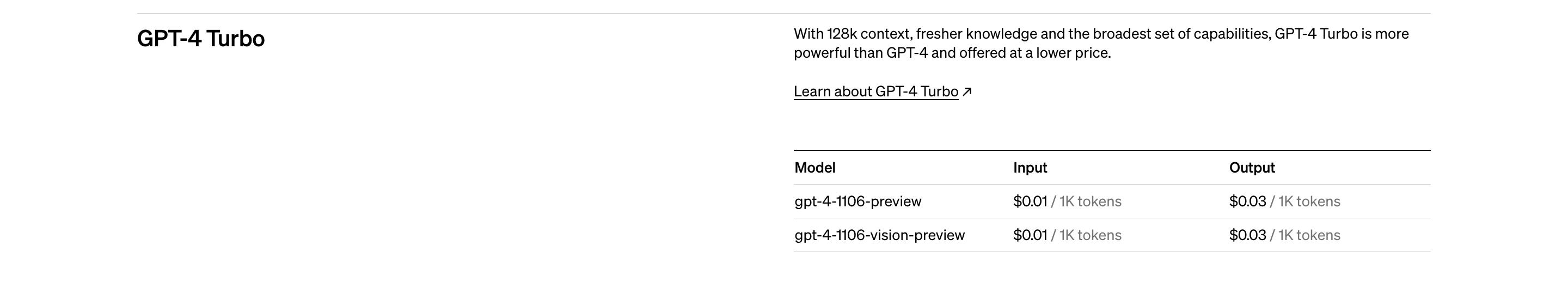

①新モデル「GPT-4 Turbo(128k)」誕生

なんと言っても、まずはこちらからでしょう。新モデル「GPT-4 Turbo(128k)」が爆誕しました。

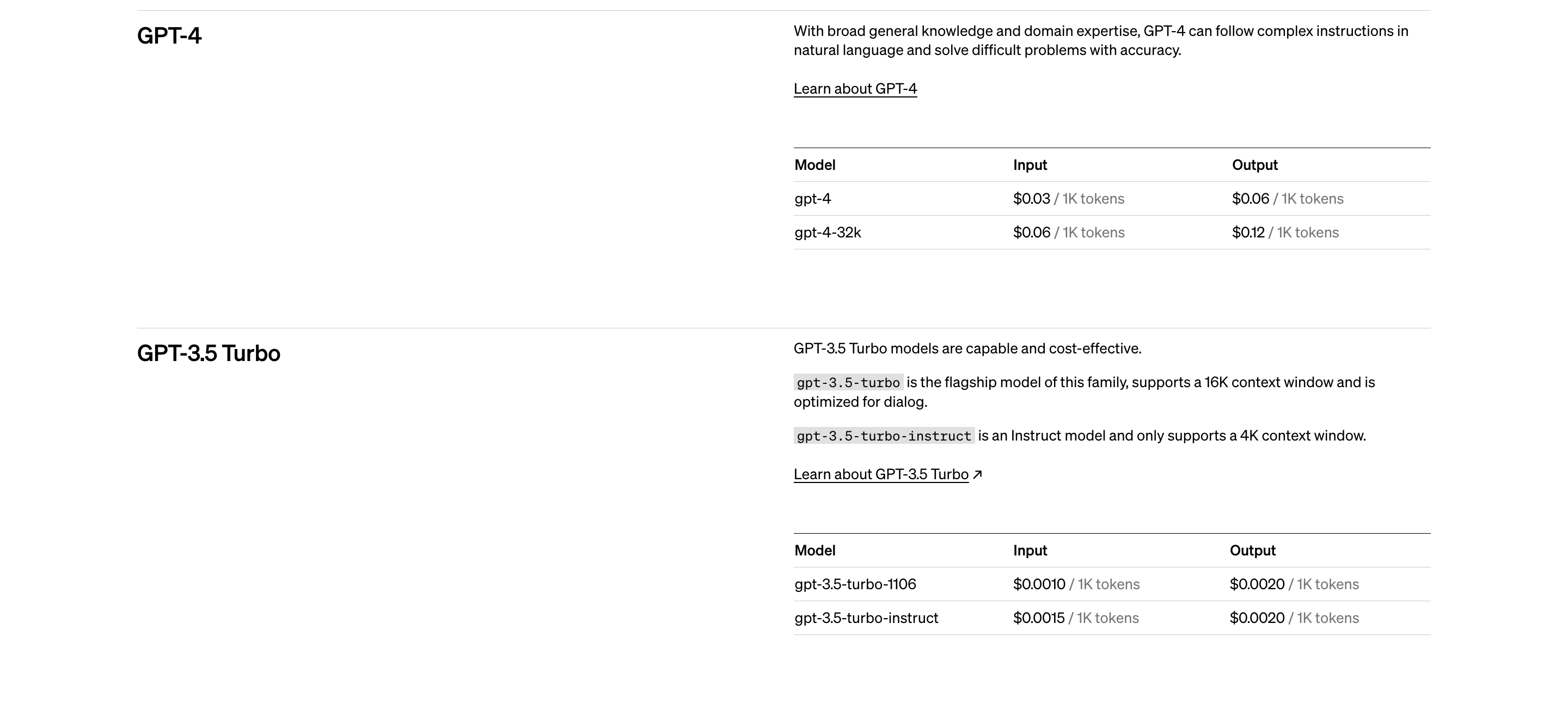

今までは、モデル「GPT-4」もしくはモデル「GPT-3.5 Turbo」を使用して開発するのが主流でした。

「GPT-4」のメリットはもちろん精度がかなり高くてトークン数も多いという部分なのですが、どうしても速度が遅かったり、料金が高くなってしまうので、「GPT-3.5 Turbo」を使う方が多かったと思います。

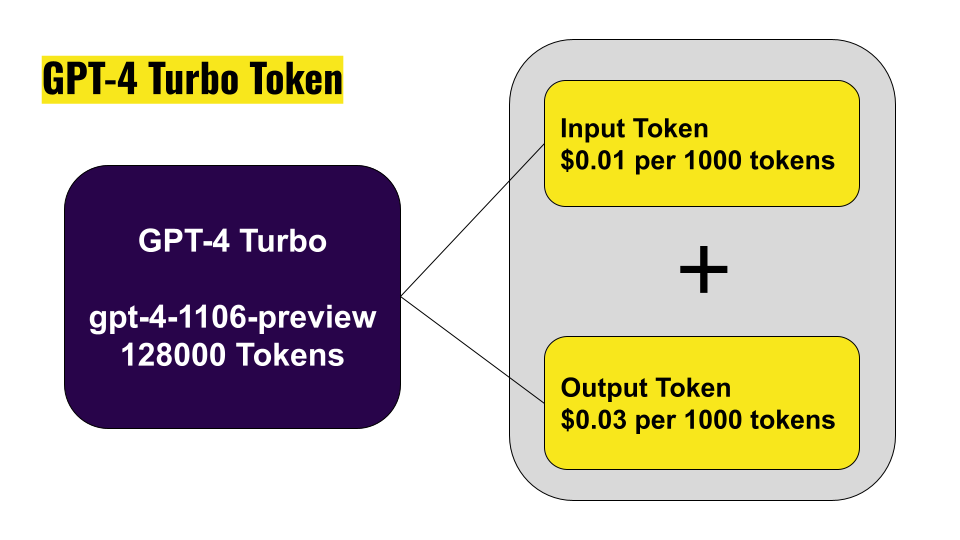

しかし、今回のアップデートで新しいモデル「GPT-4 Turbo(128k)」の誕生によって、精度は高いままで今までの弱点であった値段が高くなってしまう問題を大幅に抑えられたり(約1/3の値段)、速度も速くなっていて、かつ利用可能トークン数も128,000トークン(日本語は1文字2~3トークンなので数万文字)と大量データにも対応することができるようになりました。具体的には、300ページ分の長文に対応できるそうです。結構分厚い本が一冊かけてしまいますね…

価格の詳細:https://openai.com/pricing

トークンに関して

トークンに関しては、下記の表をご確認ください。もしくは、Udemy講座の中で丁寧に解説していますので、講座のセクション5のセッション21をご確認ください。

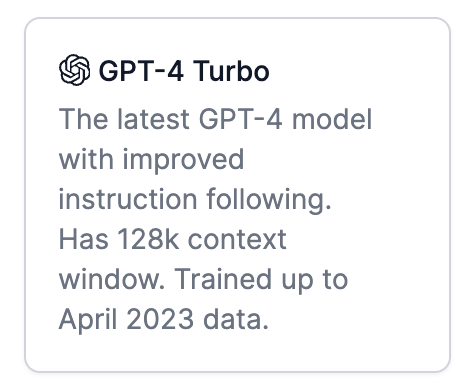

2023年4月までの情報も学習済み

今までは、学習済みのデータが2021年9月までのものであったのが、今回の新モデル「GPT-4 Turbo(128k)」には2023年4月までの学習済みのデータが使用されています。

直近起きた出来事は情報として取得することはできませんが、これも嬉しいアップデートニュースですね。

Rate Limit 引き上げ

1分間あたりで処理できるトークン数(TPM: tokens per minute)が倍になりました。RateLimitErrorは、APIを使用していると頻繁に発生してしまうエラーだったため、地味に嬉しいですね。

また、Rate Limit の引き上げは「GPT-4 Turbo(128k)」だけでなく、GPT-4のユーザー全員に適応されるとのこと。

②定番モデル「GPT-3.5 Turbo」の進化

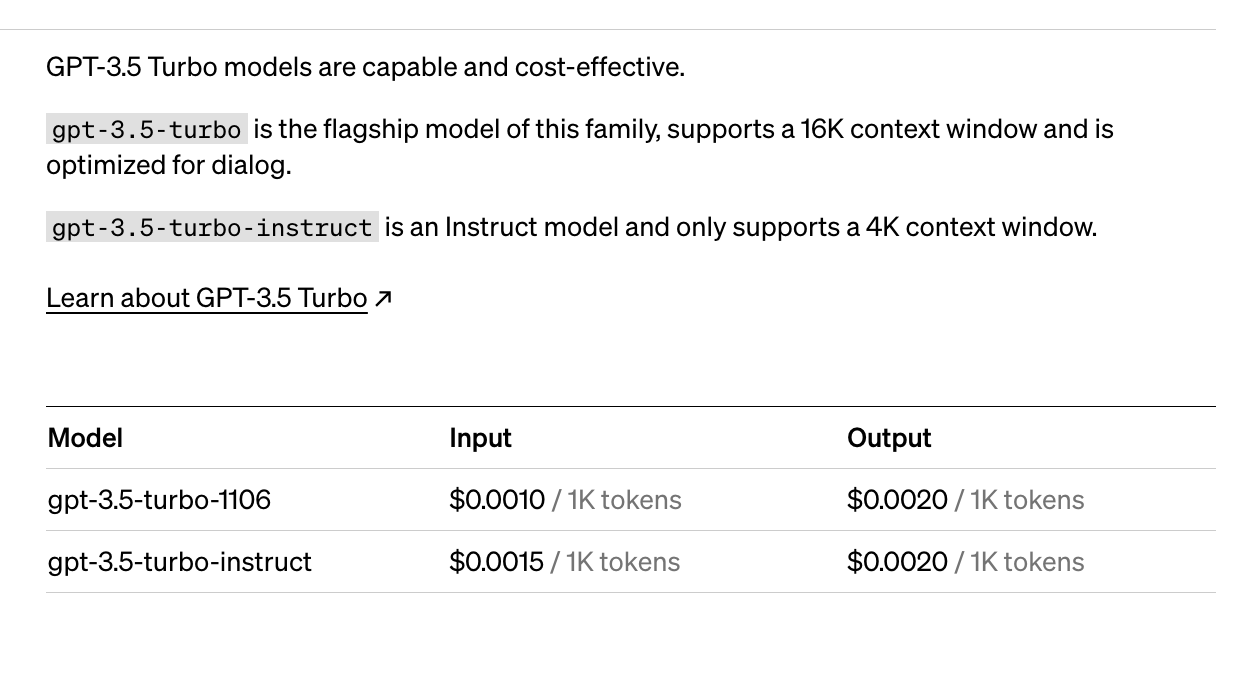

新しいモデルが出ただけでなく、既存のモデル「GPT-3.5 Turbo」も精度が高くなり、さらに安く利用することができるようになりました。GPT-4系のモデルは有料会員や申請した人しか使えないので、「GPT-3.5 Turbo」のモデルがアップデートされるのも嬉しいですね。具体的なアップデートは下記の通りです。

16Kがデフォルト化

gpt-3.5-turbo-1106 がデフォルトになり、4Kトークンから16Kトークンまで(4倍の文量)利用できるようになりました。また、入力トークンが$0.0015/1Kトークンから$0.001/1Kトークン(2/3の値段)で利用できるようになりました。(出力トークンは$0.002/1Kで変化なし)

低価格で長いコンテキストが「GPT-3.5 Turbo」で利用可能になったのは、ありがたいですね。

Parallel function calling(パラレルファンクションコーリング)

Function Calling による関数呼び出しを、複数でも可能になりました。これで、例えば「メールを送る関数」と「カレンダーに予定を追加する関数」を同時に実行するためのレスポンスを返せるようになりました。

Function Calling について:https://youtu.be/7EVi8ptQNbE

形式指定の精度改善と「JSON mode」追加

「CSV形式にしてほしい」などの形式指定の精度が38%改善されたみたいです。また、新しく「JSON mode」というのが追加され、response_format で { "type": "json_object" } と指定すると、JSON形式で出力できるようになりました。

JSON mode について:https://platform.openai.com/docs/guides/text-generation/json-mode

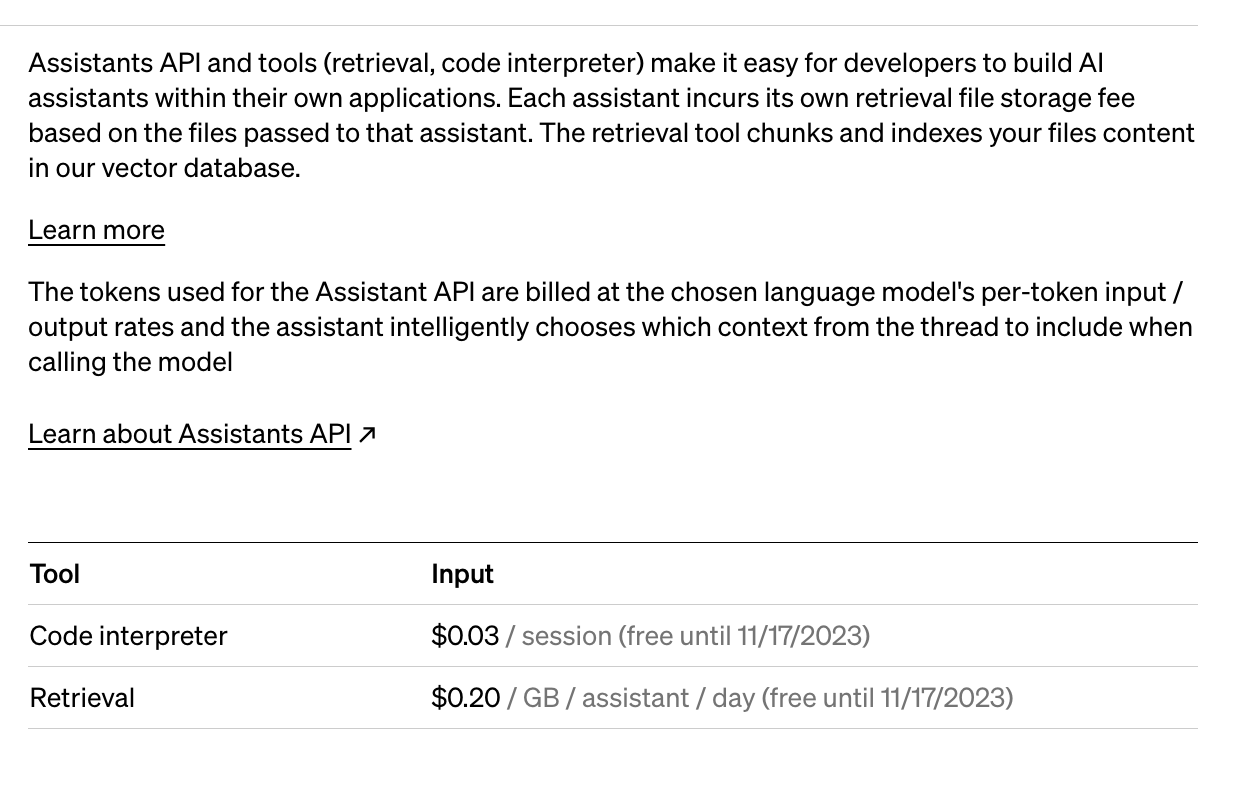

③ベータ版「Assistants API」リリース

新しくベータ版として「Assistants API」が誕生。

「Assistants API」では、「Function Calling」や「Advanced Data Analysis(旧Code Interpreter)」、「Retrieval」などの、単体でも便利と言われていたツールを、自分のアプリケーションの中で人工知能エージェントとして使える機能。今までは、「LangChain」などを用いて実装可能でしたが、OpenAI公式の「Assistants API」として使用できる様になったため、超便利と話題になっています。

OpenAI社のプラットフォーム上のPlaygroundでコードを書かずに「Assistants API」を試すことができますので、実際に試してみても面白いかもしれません。

PlaygroundのURL:https://platform.openai.com/playground

④チャット機能だけではない「イケてるスタメンAPIたち」

新しいモデルが何個かAPIで使用できるようになりました。どれも強力すぎます…。一個一個丁寧に解説していきます。

画像読み込み「GPT-4 Turbo with vision」

画像を読み込んでAIが処理することが可能になりました。

モデル「GPT-4 Turbo」で、キャプション生成や視覚分析などを可能にするビジュアル入力が可能になります。APIを利用したい場合 gpt-4-vision-preview のモデルを使用してアクセスすることが現在は可能ですが、この機能も年内に「GPT-4 Turbo」に統合されて使用可能となるそうです。

APIの使用金額は、入力する画像の画素数に応じて追加料金がかかります。例えば「1080 × 1080」ピクセルの画像の場合、$0.00765かかります。だいたい一枚1円くらいですね。

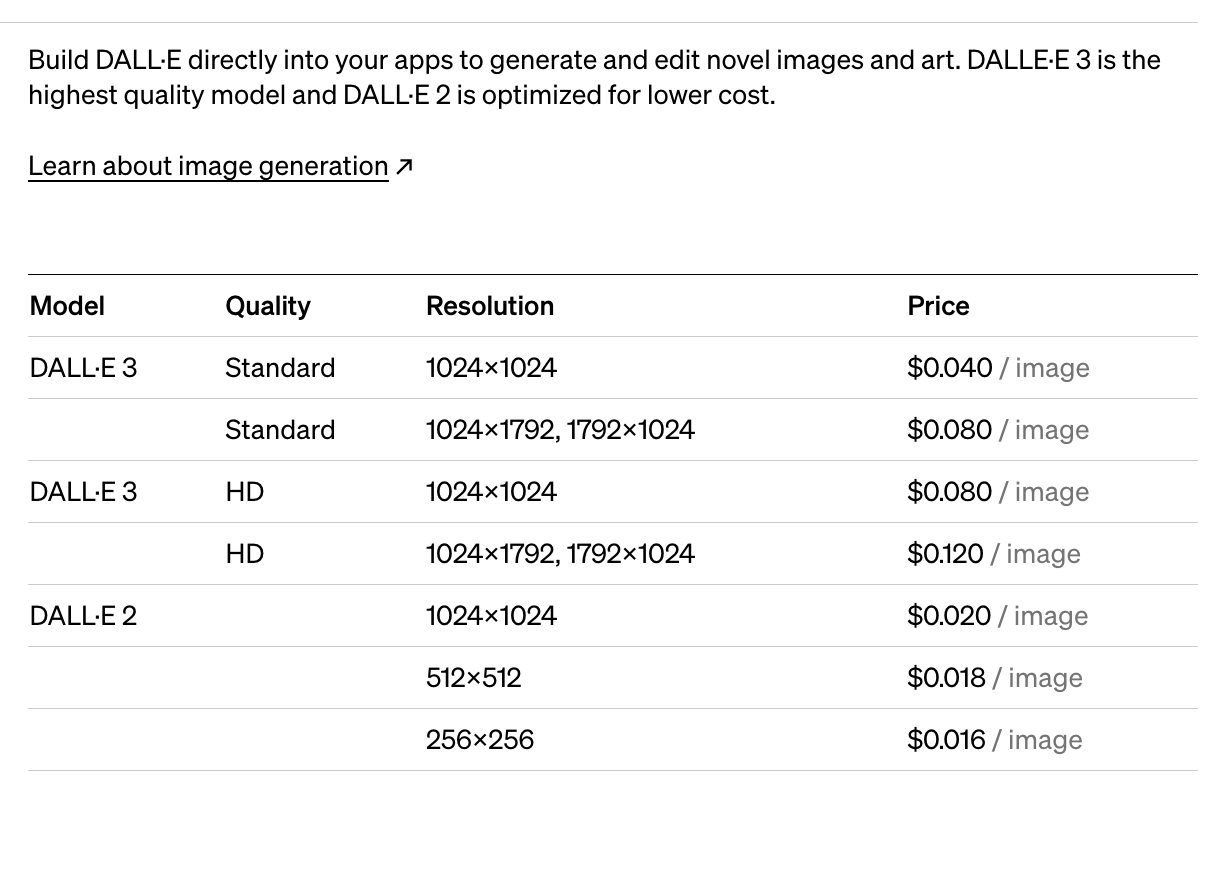

画像を生成「DALL·E 3」

OpenAI社の画像生成は元々「DALL·E 2」として使用することができました。しかし、先月発表されたこの「DALL·E 3」は凄いと、話題になっていました。APIを利用したい場合 dall-e-3 のモデルを使用してアクセスすることが可能です。

自分のアプリ内で、プロンプトを入力すると指示内容に応じて画像を生成してくれます。

DALL·E 3:https://openai.com/dall-e-3

色々と活用方法があると思います。使用方法に関しては、以前YouTubeで動画にもしているので、もしよければご覧ください。

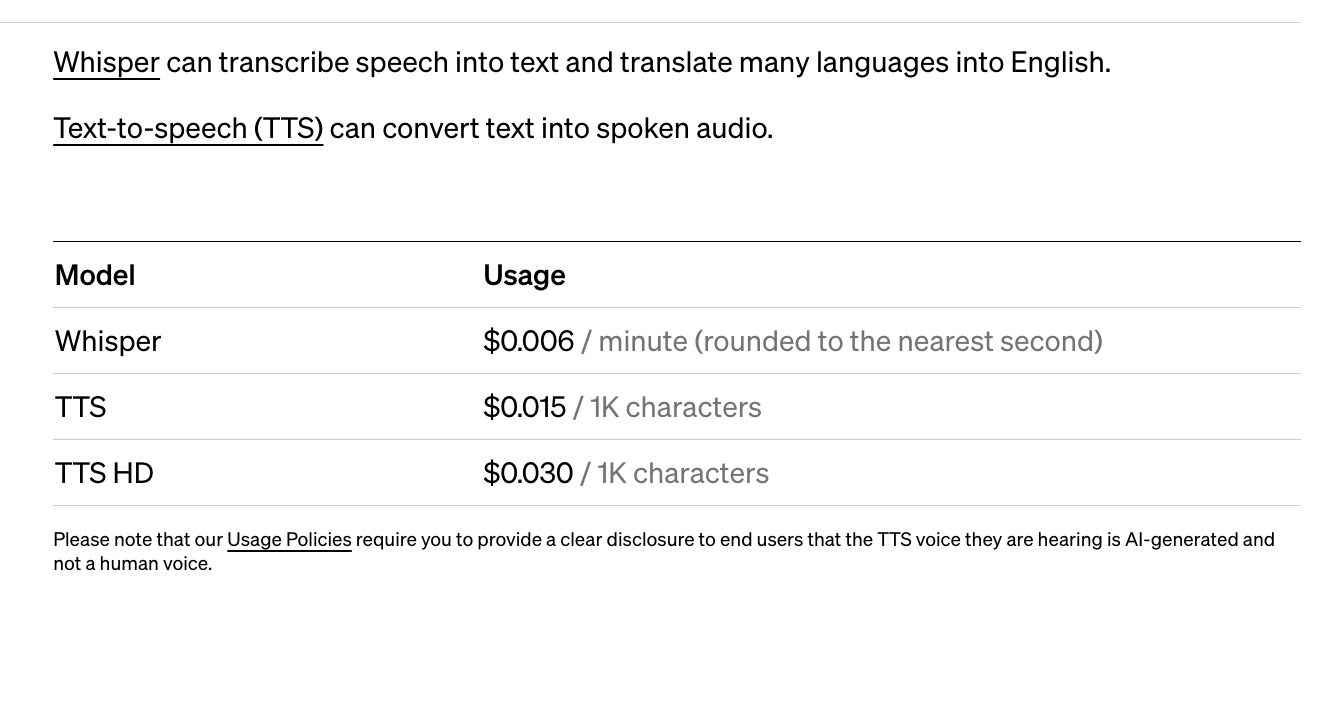

音声を生成「Text-to-speech (TTS) 」

音声生成AI「Text-to-speech (TTS)」では、テキストを読み上げることができてしまいます。

下記の4種類の男性の声(Alloy、Echo、Fable、Onyx)と2種類の女性の声(Nova、Shimmer)が用意されており、デフォルトでは「mp3」形式でアウトプットを返してくれます。他にも下記の形式でアウトプット方法が可能です。

- OPUS(ライブ配信やコミュニケーション用)

- AAC(YouTubeやアプリ開発用)

- FLAC(アーカイブなどの圧縮用)

音声に関しては、どれもとても自然な声ですので、ぜひ下記のリンクから声を聞いてみてください。

Text-to-speech(TTS):https://platform.openai.com/docs/guides/text-to-speech

サンプルコード

from pathlib import Path from openai import OpenAI client = OpenAI() speech_file_path = Path(__file__).parent / "speech.mp3" response = client.audio.speech.create( model="tts-1", voice="alloy", input="Today is a wonderful day to build something people love!" ) response.stream_to_file(speech_file_path)

文字起こし「Whisper v3」(実装予定)

今までもWhisperという文字起こしのAIは存在していましたが、この度モデルがバージョンアップして「Whisper v3」として性能改善されました。APIを利用したい場合 Whisper large-v3 のモデルを使用してアクセスすることが将来可能になるそうです。

Whisper v3:https://github.com/openai/whisper

⑤自分だけのオリジナルChatGPTを作成できる「GPTs」

ChatGPT上で手軽にGPT搭載ツールを作れる「GPTs」という新機能が導入されました。

特定のタスクや指示、データ、機能を組み合わせて、カスタマイズされたChatGPTのモデルを作成することができます。また、モデルを作成する人のことを「GPT Builder」と呼ぶそうです。(笑)

GPTsのよいところは、ノーコード(コーディングしない)で作成することができるところ。つまり、プログラミングに関する難しい知識は一切必要ありません。また、個人用、会社内部用、公開用など、さまざまな用途に合わせて作成することができます。なので、特定の目的に合わせてオリジナルのChatGPT「GPTs」を作成でき、さらにそのGPTsを他の人に共有することも可能です(次に解説するGPT Storeで共有可能)。

GPTsにはプラグインのように独自のカスタムアクションを定義することができるので、既にある機能に加えて、さらに外部APIをGPTに利用させることができます。つまり、GPTsでデータベースを管理したり、メール送信などなど、さまざまなアシスタントとして接続が可能になるそうです。

オリジナルChatGPT「GPTs」の作り方

GPTsを作成するには「Create」と「Configure」という機能で開発していきます。

Create(作成)

どんな機能を備えたChatGPTにするか文章を入力するだけで、作成することができます。(神)

また、「どのような問題を解決したいか」といった課題を入力しても開発可能です。(神)

プログラミングを書くのではなく、日々人間が使っている言葉(自然言語)で作成できてしまうので、恐ろしい時代がやってきました。

Configure(構成)

作成するオリジナルのChatGPTに追加情報を与えられます。ファイルをアップロードすることで、GPTs開発に必要な情報を直接学習可能です。(神)

また、「Web Browsing」や「DALL-E 3」、「Advanced Data Analysis(旧Code Interpreter)」など、これまで既にChatGPT画面に存在していたツールを使用するかどうかも選択できます。なので、自分のオリジナルChatGPTにウェブ検索や画像作成、データ分析など、テキストの出力以外の有力な機能をGPTsに搭載可能です。

GPTs公式ページ:https://openai.com/blog/introducing-gpts

⑥つくったGPTsは販売しよう「GPT Store」

カスタマイズしたオリジナルのChatGPT「GPTs」を公開して、共有できるのが「GPT Store」です。

「GPT Store」は2023年11月後半に実装が開始される予定で、公開されたGPTsは検索可能になり、リーダーボードに表示される予定とのこと。

将来的には、自分で作成したGPTsを誰かに使ってもらって、使ってもらった人数に応じて収益を得ることができるようにもなるようです。また、「GPT Store」は、「生産性」「教育」「エンターテイメント」といったカテゴリー別になるそうです。

こういうのは先行者利益がものすごいと思うので、今のうちから触ってアイディアを練っておいて、「GPT Store」が公開されると同時にオリジナルのGPTをリリースした方が良いかもしれませんね。

GPTs公式ページ:https://openai.com/blog/introducing-gpts

⑦OpenAI社のモデルをカスタマイズ

企業やデータサイエンティストの方向けの内容ですが、「Assistants API」よりもさらに一歩踏み込んで、より強力なモデルの作成が可能になりました。強化方法は、「Fine-tuning(ファインチューニング)」と「Retraining(リ・トレーニング)」の2種類があります。

Fine-tuning(微調整)

以前までは、GPT-3.5までしか「Fine-tuning」をすることができませんでしたが、限定したユーザーに対してGPT-4でもファインチューニング・コンソールの中で「Fine-tuning」をすることができるようになりました。

より繊細に出力結果を調整することができるようになったことで、用途に応じて精度の高い情報を抽出することができます。

Retraining(再学習)

さらに限定したユーザーに対して、「Retraining」ができるようにもなりました。しかし、「Retraining」での開発には、最低十億以上のトークンという大規模な独自データセットを準備する必要があるとのことですので、かなり高額になることが予想されます。

また、「Retraining」はデータを扱うための専門知識が必要なため、財政面の心配だけでなく、深い人工知能分野における知見も必要になりそうです。

モデルカスタマイズの登録方法:https://openai.com/form/custom-models

⑧「Consistency Decoder」オープンソース化

またさらに、より開発者向けのコアな内容ですが、「Stable Diffusion」の一貫性デコーダー(Consistency Decoder)のオープンソース化が、最後にちょっとだけアナウンスされました。

「Consistency Decoder」に頼ることによって、一般的に使用されている「VAE decoer」を使うよりも精度が高く、かなり高速化できるようになりました。

https://github.com/openai/consistencydecoder

⑨本家ChatGPTのバージョンアップ

APIなどの開発者向けのツールではなく、普段使っているChatGPTもレベルアップしました。

ChatGPT Plus の精度向上

「GPT-4 Turbo(128k)」だけでなく、ChatGPT Plus のチャットでも2023年4月までの学習データをもとに回答が出力結果が表示されるようになりました。

Googleや、X社が出しているAIチャットよりは情報鮮度には劣りますが、今まで以上に最新の情報に基づいた出力が返ってくるのは有難いですね。

ChatGPTのブラウザのUI改善

これまでは、「Web Browsing」や「DALL-E 3」、「Advanced Data Analysis(旧Code Interpreter)」など、各機能を使うためにタブの切り替えが必要でしたが、「GPT-4」として一つのページに統一されました。

UIは、今後もどんどん進化していくと思いますし、ブラウザの一般的な画面がこれからどう変わっていくのかは注目で楽しみですね。

ファイル読み込み機能

PDFなどのファイルを読み込ませても、その内容についてチャットで答えてくれるようになるとのことです。

凄いことだけど、もう「これくらい、まぁできるよね」と思ってしまう自分がいます。(怖)

⑩クリエイターを守る「Copyright Shield」

「Copyright Shield」によって著作権が保護される仕組みが実装されました。

これだけAIで便利な世の中になってくると、やはり「そのデータはどこから学習したのか」というのは気になりますよね。学習データによっては、訴訟が生じてしまう事例も頻繁に出てきているため、このような事前対策はとても大切ですね。

もし、OpenAIのサービスを利用中に著作権侵害に関する法的請求が発生した場合、OpenAI社が守ってくれるだけでなく、発生した費用を支払ってくれるそうです。(凄)

さいごに

いかがでしたでしょうか?それぞれの内容だけでも記事や動画がつくれてしまう程、素晴らしいアップデートがてんこ盛りでしたね。

本家のブログ:https://openai.com/blog/new-models-and-developer-products-announced-at-devday

LINEでOpenAI社のAPIを使ったチャットボットの作り方を、Udemy講座も出しています。まだChatGPTを使ったAI開発をあまりしたことがない方や、非エンジニアの方にも分かりやすく、プログラミングの基礎から丁寧に2時間半かけて解説しています。是非Udemy講座も併せてご受講いただけると幸いです!

ストリートアカデミー(ストアカ)というサイトでも、「LINE × ChatGPT」の講座を開催しています。こちらも、お気軽にご受講ください!

お仕事などの依頼は下記メールアドレスへどうぞ。

nj.takayuki@gmail.com

【メタバース入門】Unity × Cluster ワールド作ろう

【1,000円 OFF優待!】

【メタバース入門】Unity × Cluster ワールド作ろう

【1,000円 OFF優待!】

プログラミングで作るLINEチャットボット|初心者向け個別レッスン

【1,000円 OFF優待!】

プログラミングで作るLINEチャットボット|初心者向け個別レッスン

【1,000円 OFF優待!】